编译/VR陀螺

最近的Meta Connect期间,Meta Reality Labs首席科学家Michael Abrash发表了主题为《焦点对话:计算的未来》的演讲。每一年大会期间,Abrash都会发表主题演讲,内容聚焦于VR、AR行业并给出相应的预测。今年,Abrash对智能眼镜上的AI助手做了展望。

目前,Meta眼镜上的Meta AI是反应式的,而且大多是瞬态的。你可以向它发出命令,比如播放歌曲或设置计时器,或者向它提问。如果问题与你所看到的内容相关,比如“这是什么?”,它就会使用摄像头捕捉图像,并进行分析并做出回应。

在美国和加拿大,Meta眼镜还推出了Live AI功能,用户可以与它进行持续对话,而无需一直说“Hey,Meta”,而且AI会持续播放你所看到的内容。但这仍然受到底层大型语言模型上下文窗口的限制,第一代Ray-Ban Meta支持30分钟的Live AI,而新一代的续航则提升到了1小时左右。

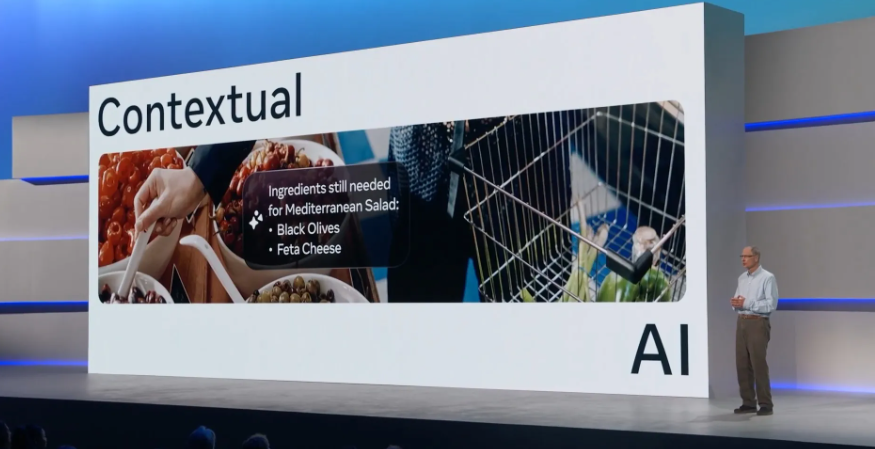

Abrash表示,支持人工智能的智能眼镜最终将发展到人工智能始终在后台运行的阶段。此外,眼镜将持续创建动态3D地图,记录你的环境、你的动作和行为,包括你与之交互的物体。眼镜将存储这些动作和交互的日志,并利用这些日志提供“情境人工智能”。

例如,你可以问“我今天消耗了多少卡路里?”,或者“我把钥匙放哪儿了?”。无需事先记录任何信息,只要你当时戴着眼镜,人工智能就能回答。

为了实现这点,需要显著提升用于实时3D环境网格划分、身体追踪和语义物体识别的芯片和算法的能效。它甚至可能需要定制的传感器和芯片,而Meta Reality Labs Research正在研发这两者。从实用性角度来看,眼镜可能还需要拥有自己的蜂窝连接,而不是依赖于手机。

值得一提的是,此前扎克伯格接受采访时也提到了“始终在线情境人工智能”,他认为相关进展会比很多人想的更快。“我不确定要花多长时间才能实现这一目标。我认为不会是五年。我认为会更快。”

来源:UploadVR

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息